接触Hadoop也快两年了,也一直没自己总结过安装教程,最近又要用hadoop,需要自己搭建一个集群来进行试验,所以就利用这个机会来写个教程以备以后自己使用,也用来和大家一起探讨。

要安装Hadoop先安装其辅助环境 java

Ubuntu下java的安装与配置

将java安装在指定路径方便以后查找使用。

Java安装

1)在/home/xx(也就是当前用户)目录下,新建java1.xx文件夹:mkdir /home/xx/java1.xx(文件名上表明版本号,方便日后了解java版本)

2)进入/home/xx/java1.xx目录下,运行安装指令:sudo /home/xx /jdk-6u26-linux-i586.bin,则生成文件夹jdk1.6.0_26,如果感觉名字太长,可以对其重命名:mv jdk1.6.0_26 jdk

也可以使用sudoapt-get install 软件包来安装java。如果想卸载java使用命令sudo rm -rf /home/xx/java1.6/jdk1.6(安装目录)

配置环境变量

进入profile文件添加环境配置,命令为sudo gedit /etc/profile 在文件的末尾添加

| 1 2 3 4 5 6 7 |

JAVA_HOME=/home/xx/java1.xx/jdk

JRE_HOME=/home/xx /java1.xx/jdk/jre

PATH=$JAVA_HOME/bin:$JRE_HOME/bin: $PATH

export JAVA_HOME

export JRE_HOME

export CLASSPATH

export PATH

|

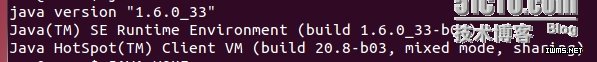

完成以上配置后重启电脑然后检验java是否安装成功在终端输入java –version 后显示

说明java安装成功。

Java安装成功后接着进入正题进行Hadoop的安装,本文先进行Hadoop的伪分布安装随后会继续更新完全分布的安装过程。

本文使用的Hadoop版本是hadoop-0.20.2,将hadoop-0.20.2.tar.gz移至当前用户目录下进行解压tar –zxvf hadoop-0.20.2.tar.gz

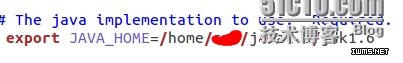

然后配置hadoop的环境变量,其配置方法和java的配置方法一样,在profile中写入HADOOP_HOME=/home/xx/hadoop

Java和hadoop的配好的环境变量如图

配好环境后可以用hadoop version 查看版本(需要重启电脑)。

接着对hadoop的配置文件进行配置。进入hadoop/conf路径下,修改hadoop-env.sh文件 sudo gedit hadoop-env.sh对其添加javahome

完成以上配置之后就可以在单机模式进行测试了

输出结果为:

出现上面的结果说明之前的步骤你都部署正确。接下来进行伪分布的配置,进入hadoop/conf目录下对core-site.xml进行编辑,添加如下内容

| 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 |

<property>

<name>hadoop.tmp.dir</name>

<value>/home/xx/hadoop/tmp</value>

</property>

<property>

<name>fs.default.name</name>

<value>hdfs://xx:9000</value>//也可以是主机的ip

</property>

对hdfs-site.xml进行编辑,添加如下内容

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

对mapred-site.xml进行编辑,添加如下内容

<property>

<name>mapred.job.tracker</name>

<value>xx:9001</value>

</property>

|

完成以上工作后,终于可以运行hadoop了,运行时要先对hdfs进行格式化(貌似跟新买一块硬盘时初次使用也得格式化的道理一样),命令为bin/hadoop namenode –format出现如下画面为成功

接着就是启动hadoop了,激动人心的时刻到了哦,bin/start-all.sh 结果出现了如下画面

貌似子节点没有启动,显示连接被拒绝,然后用jps查看下启动了几个任务

子节点真的没有起来,看来伪分布也得配置ssh,接下来的任务就是继续配置ssh了

1.先命令

| 1 |

sudo apt-get installssh

|

2.然后配置可以无密码登陆本机:

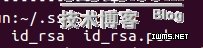

由于本文是伪分布的,只在自己机器上安装就可以了,进入用户目录创建.ssh 文件 mkdir .ssh 。之后进入.ssh ,在此路径下执行生成密钥的命令ssh-keygen –t rsa(rsa是加密方式),一路回车下去就行了,成功之后在.ssh文件中查看文件 ls –a 可以看见生成两个文件

表示密钥生成成功。接下来就是产生公钥,命令

| 1 |

cp id_rsa.pub authorized_keys

|

3.验证ssh已安装成功及无密码登陆本机

Ssh是否安装成功可以像检验java hadoop那样查了版本号ssh –version

无密码登陆主机命令sshlocalhost ,第一次登录时会询问你是否继续链接,输入yes即可以进入。

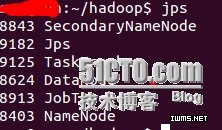

完成以上操作hadoop的伪分布模式也安装成功了,运行bin/start-all.sh 启动,然后用jps查看启动了那些服务,成功启动的服务如下图

猜您喜欢:

1.Hadoop读写文件时内部工作机制是怎样的

2.基于Hadoop平台的云存储应用实践

3.Hadoop中的一些基本操作

XSKY开发了基于对象存储XEOS的专用Hadoop HDFS高性能客户端XSKY HDFS Client。

原先支持Hadoop的四大商业机构纷纷宣布支持Spark,包含知名Hadoop解决方案供应商Cloudera和知名的Hadoop供应商MapR。

证券交易数据属于典型的结构化数据,采用Sql on Hadoop[1]技术,既可用廉价PC服务器获得良好的容量线性扩展能力,又可提供便于统计分析的SQL接口方便数据应用开发。

本文总结Hadoop十个认识误区,帮助大家更好地理解和学习Hadoop。由于Hadoop本身是由并行运算架构(MapReduce)与分布式文件系统(HDFS)所组成,所以我们也看到很多研究机构或教育单位,开始尝试把部分原本执行在HPC 或Grid上面的任务

数据产生后,意味着数据的采集工作已经完成,那么数据的输入与有效输出问题怎么破解?

【聚焦搜索,数智采购】2021第一届百度爱采购数智大会即将于5月28日在上海盛大开启!

本次大会上,紫晶存储董事、总经理钟国裕作为公司代表,与中国—东盟信息港签署合作协议

XEUS统一存储已成功承载宣武医院PACS系统近5年的历史数据迁移,为支持各业务科室蓬勃扩张的数据增量和访问、调用乃至分析需求奠定了坚实基础。

大兆科技全方面展示大兆科技在医疗信息化建设中数据存储系统方面取得的成就。

双方相信,通过本次合作,能够使双方进一步提升技术实力、提升产品品质及服务质量,为客户创造更大价值。